AI-AI-AI Podcast è lo spazio informativo sull’Intelligenza Artificiale del magazine MagIA.news, progetto di AI Debating finanziato dal Dipartimento di Culture, Politiche e Società in collaborazione con il Dipartimento di Informatica dell’Università di Torino.

Al di là del formato audiovisivo curato e coinvolgente – che, si sa, rende i podcast più fruibili e accattivanti rispetto alla lettura di un articolo –, cosa rende davvero efficace questo progetto, appena approdato su Spotify e YouTube?

I new scholars dell’era digitale

AI-AI-AI Podcast funziona innanzitutto per il concept accessibile dietro i suoi episodi divisi tra 30 minuti di AI aperitivi per approfondire tematiche specifiche e 10 minuti di Non AI capito per demistificare entusiasmi e paure relativi l’Intelligenza Artificiale a partire da dubbi e perplessità diffusi.

Inoltre, funziona perché i protagonisti del podcast sono esperti giovanissimi che si presentano con una formula lucida e determinata: “siamo dei ricercatori, quindi offriamo una tipologia di informazione precisa e consapevole”.

Marta Baronio – ricercatrice -, Federico Torrielli – dottorando -, Giovanni Siragusa – postdoc – e Mattia Corsini – studioso di filosofia -, rappresentano sicuramente la formula magica del podcast: una gioventù che conosce e comprende, ma che soprattutto vuole conoscere e comprendere ancora di più e che non teme affatto di espandere il proprio mestiere, affrontandone e divulgandone le tematiche, attraverso la comunicazione social e podcast.

Talvolta il mondo accademico può mostrare una certa diffidenza nei confronti della divulgazione social e mediatica dei materiali di ricerca. Pertanto, è interessante vedere come invece la generazione social, una volta entrata nel mondo accademico – a partire dal dottorato -, scelga comunque di superare gli stereotipi, facendo informazione e portando la ricerca al di fuori delle aule universitarie. Questo approccio, per certi versi innovativo, per altri conforme alla realtà dell’era digitale – dipende dai punti di vista -, rappresenta il nuovo orizzonte della divulgazione democratica del sapere, precisamente nelle figure dei new scholars che dedicano tempo alla selezione e alla preparazione di contenuti specialistici anche per un pubblico non universitario di non addetti ai lavori.

Il podcast che non pensavi ti servisse

Lo scorsa settimana è uscito il primo episodio di AI-AI-AI Podcast: l’AI Aperitivo di 34 minuti dal titolo “Perché l’IA inventa assurdità? Le allucinazioni spiegate”.

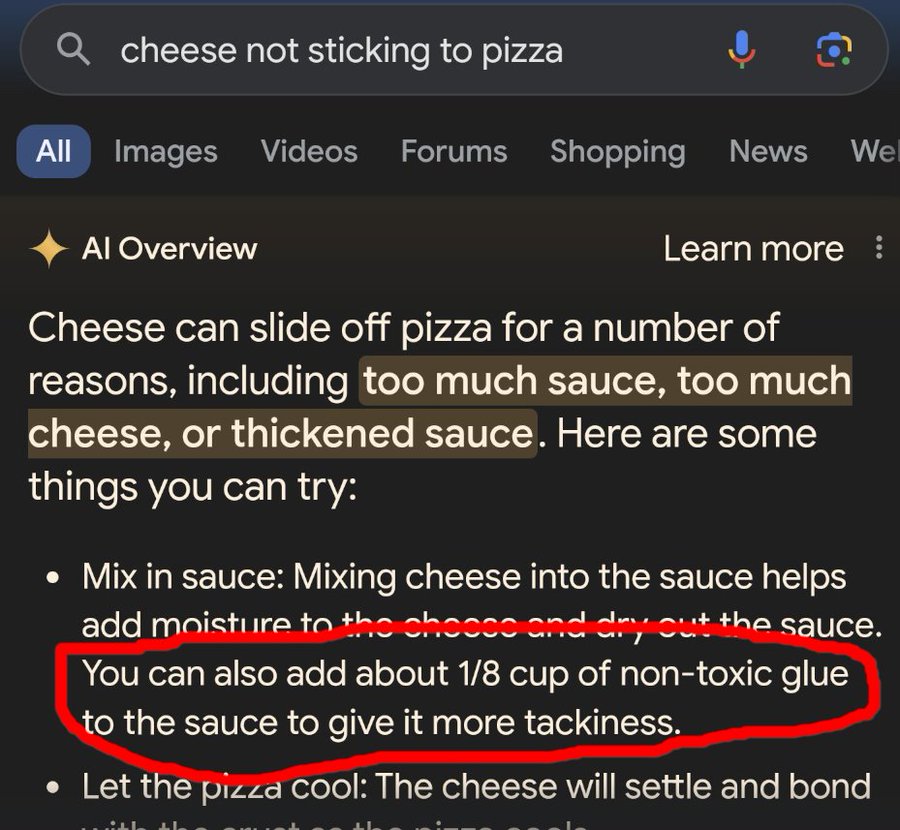

Nell’anteprima si ascoltano i giovani ricercatori parlare di “colla sulla pizza”: un’eresia gastronomica, se non semplicemente una sbadatezza dell’AI Overview di Gemini – i riassunti che da qualche tempo appaiono sul motore di ricerca Google. L’utente ha bisogno di un consiglio per non far scivolare il formaggio sulla pizza e la soluzione consigliata è quella di aggiungere della “colla non tossica” direttamente alla salsa di pomodoro, in modo da renderla “più appiccicosa”.

Dal racconto di questo spiacevole incoveniente, ha inizio l’aperitivo informativo e i giovani ricercatori cominciano a discutere sul – forse – limite, – forse – capacità, di confabulazione che gli LLM (Large Language Model) spesso e volentieri dimostrano – sottolineando che Chat GPT non è un LLM, ma un chatbot basato su un LLM.

Come si spiega allora il colla-sulla-pizza gate? Gli LLM funzionano perché completano i testi, giocano a riempire le parti mancanti dei puzzle – ovvero le nostre richieste -, ma non sempre inseriscono il pezzo mancante corretto. I giovani ricercatori evidenziano l’importanza che l’utente tenga a mente che si tratta di modelli dotati di un grande vocabolario, addestrati quindi su grandi quantità di dati, talvolta utilizzati in modo improprio e non pertinente.

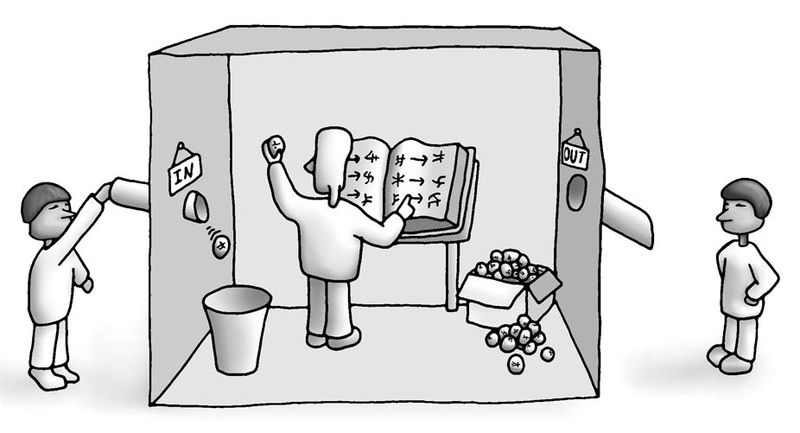

Questi dati non vengono elaborati in quanto testi composti di frasi e parole con un significato: Chat GPT, ad esempio, la semantica la lascia da parte, per concentrarsi esclusivamente sulla sintattica. I dati testuali sono elaborati in token – parti di parole, ad esempio “and-ai”, “and-rei”, dove si riconoscono tre token totali, quali “and-“, “-ai” e “-rei”. Questi token, in realtà sono numeri dati in pasto al modello finché per generare output, o meglio, “la continuazione più probabile di quello che abbiamo dato in input”. Insomma, “siamo noi che assegniamo senso alle parole”, dice il dottorando Federico Torielli.

La confabulazione come marca stilistica

Va tenuto a mente che “per quanto riguarda le proprietà propriamente umane, c’è sempre qualcosa che manca a queste Intelligenze Artificiali”, questo perché “non hanno comprensione”. Troppo spesso l’utente tende a dimenticarsi che ha che fare con un’interfaccia sicuramente utile sotto certi aspetti, ma anche riduttiva su altri. Gli errori che Chat GPT compie nel momento in cui “”sente”” la pressione di rispondere ad un quesito, si configurano come “confabulazioni” più che “allucinazioni”. Accade che il modello “si trova a narrare cose che noi chiediamo” riempiendo i vuoti, le lacune di informazione, “con fantasia”. I ricercatori sottolineano: “la confabulazione è prevista”, pertanto “dobbiamo noi tenerla in considerazione”.

Un promemoria fondamentale per ogni utente che decide di interfacciarsi con Chat GPT è ricordare che questi modelli agiscono fornendo output grammaticalmente corretti e talvolta “azzeccati”, pur sempre in una cosiddetta “finestra di contesto”, ovvero la chat. Questo significa che non hanno memoria.

I protagonisti di AI-AI-AI Podcast parlano di “yappare”, ovvero “parlare costantemente con persone che a stento ti ascoltano o si limitano semplicemente ad annuire, pensando che siano interessate al tuo discorso”. È questo che fa Chat GPT con l’utente: opera attraverso un’interfaccia che, pur sembrando ricalcare la nozione tradizionale di conversazione, si impone in realtà come un surrogato spesso limitante.

Uno spazio di filosofIA

Ciononostante, sorge il dubbio che correggere le confabulazioni di questi modelli possa essere una limitazione degli stessi. È possibile applicare una correzione dei modelli ‘a monte’, sul training set – ovvero i dati di addestramento – oppure ‘a posteriori’, sull’output. Ad ogni modo, la confabulazione, la speculazione e l’immaginazione sono caratteristiche tipicamente umane, affini alla dimensione della creatività: e allora, questo fa di Chat GPT un modello ‘stranamente’ creativo? Insomma, uno storyteller?

I ricercatori si chiedono perfino se l’IA possa diventare “il superuomo di Nietzsche”. Per ora, Chat GPT si muove nella dimensione della performance e della manipolazione sintattica, lontano quindi da quella della semantica, su cui invece agisce l’essere umano – in questo senso viene citato l’esperimento mentale della Stanza Cinese di John Searle.

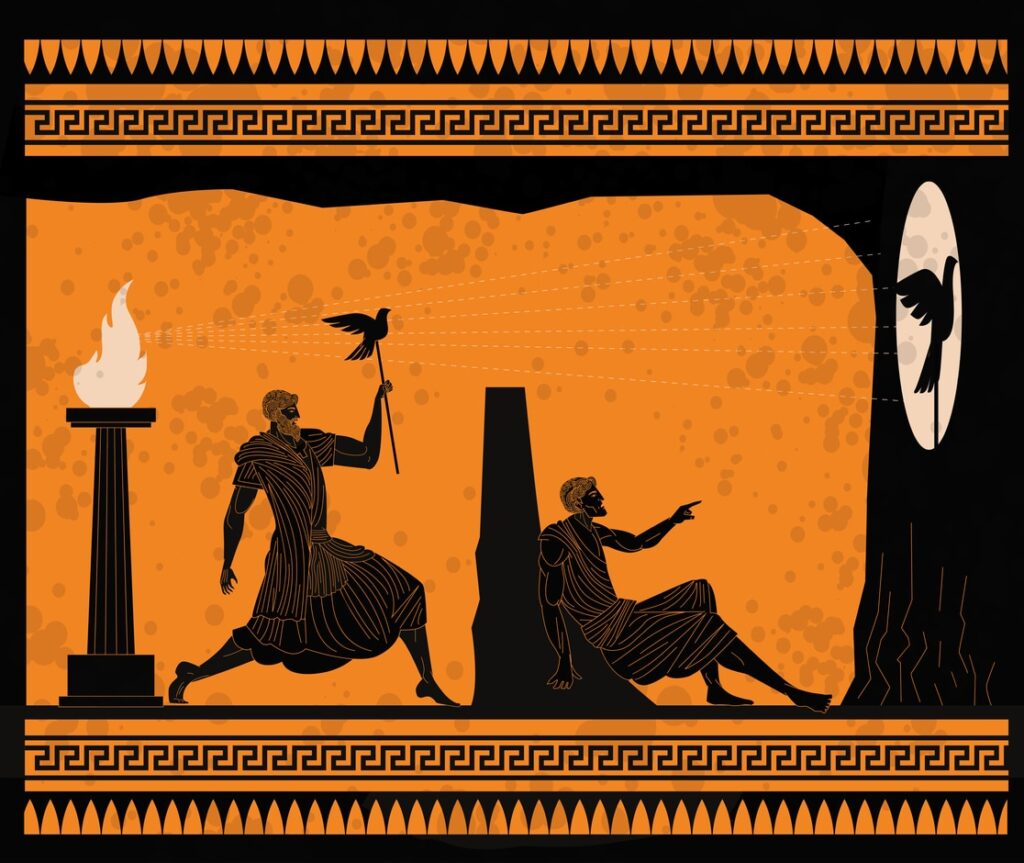

Viene – giustamente – chiamato in causa anche Platone con il mito della caverna, celebre allegoria de La Repubblica che descrive uomini ‘chiusi’ fin dalla nascita in una caverna, costretti a non vedere la luce del sole ma solo le ombre di oggetti reali proiettate su una parete. Per loro, quelle ombre sono l’unica realtà possibile.

Similmente, l’utente tende ad antropomorfizzare o meglio “personificare” i modelli, attribuendo loro una semantica che in realtà non possiedono. Al contrario, studiando ciò che si cela dietro gli LLM e analizzando le situazioni pratiche, ecco che le ‘vere’ realtà vengono a galla. Tra queste, nell’episodio vengono menzionati i “muratori digitali”, “il nuovo proletariato” dell’era digitale: i lavoratori invisibili che alimentano queste tecnologie, le quali, per rispondere ad una sola domanda dell’utente, possono arrivare a consumare fino a 15 litri d’acqua.

A questo punto, l’informazione – e la divulgazione – AI è importante: nel primo episodio del podcast, i giovani ricercatori prendono in considerazione la necessità e l’utilità di integrare l’IA anche nei percorsi di formazione universitaria umanistici e nelle scuole, evitando così di ‘nascondere la polvere sotto il tappeto’ riducendo una tecnologia impattante come questa ad un semplice tabù.

Un pappagallo stocastico come motore di ricerca

Il secondo episodio del podcast è in realtà il primo del secondo format, ovvero Non AI capito, in cui si analizzano questioni che suscitano dubbi e perplessità riguardo l’IA. Nel primo episodio, “Assistenti AI o semplici pappagalli?”, Marinella Quaranta – dottoranda -, Ilaria Amantea – ricercatrice – e Ivan Spada – assegnista di ricerca – toccano di nuovo l’ambito della confabulazione – come errore di Chat GPT – ma soprattutto della “personificazione” – come errore dell’utente.

Di fronte a frasi corrette e a contesti coerenti, l’impressione è che “qualcuno risponda” per davvero, quando in realtà si tratta di veri e propri “pappagalli stocastici”, ovvero modelli che ripetono “le cose più probabili semplicemente perché le hanno viste da un’altra parte”. Infine, Chat GPT non è un motore di ricerca: non attinge a fonti certificate, né presenta differenti punti di vista sulle questioni richieste.

Una realtà polipesca

AI-AI-AI Podcast è un ottimo strumento di comprensione e chiarimento per i non addetti ai lavori – e non solo -, uno spazio per portare in tavola argomenti attuali e riflessioni universali a partire da un’unica dimensione: quella dell’Intelligenza Artificiale, così controversa, così impattante e così “polipesca” da abbracciare non solo l’ingegneria e l’informatica, ma la filosofia e le scienze umane.

La forza di questo format è sicuramente la quota ‘giovani esperti’, oltre che l’ambientazione rilassata in cui avvengono le conversazioni, né eccessivamente entusiasta, né cinicamente catastrofista nei confronti dell’AI, ovvero quella di un aperitivo in cui alcuni amici chiacchierano sulla realtà accogliendola in tutte le sue possibili sfumature, perché in fondo, non si tratta di nient’altro se non realtà.

Riferimenti

AI Apertivo Ep. 1, “Perché l’IA inventà assurdità? Le allucinazioni spiegate“, 15 aprile 2025

Non AI Capito Ep. 1, “Assistenti AI o semplici pappagalli?“, 29 aprile 2025

Lascia un commento